spark源码编译-Zinc报错简析

参考链接:http://spark.apache.org/docs/latest/building-spark.html

1.下载spark源码

git clone git://github.com/apache/spark.git2.

# Apache Hadoop 2.7.X and later

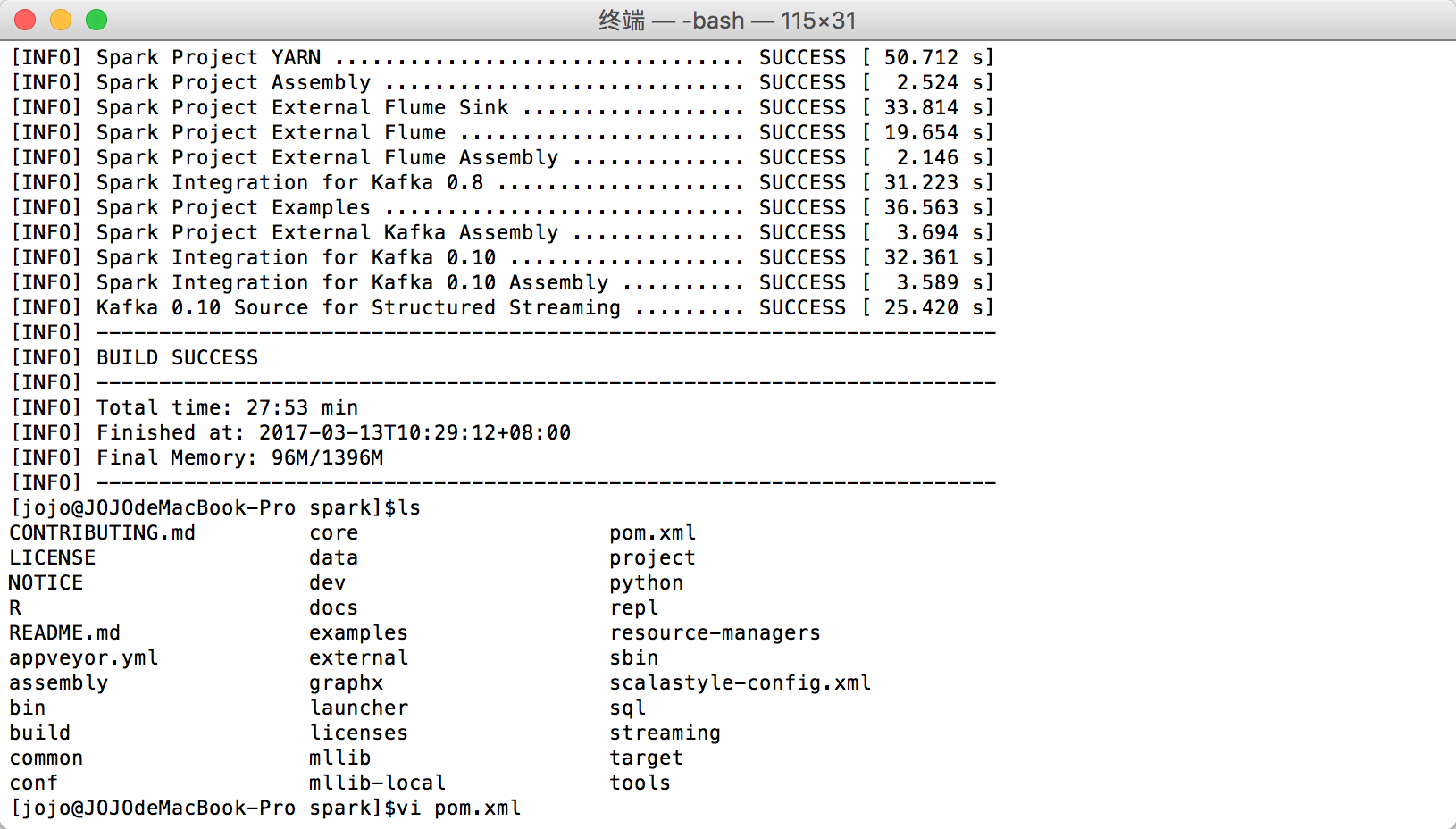

./build/mvn -Pyarn -Phadoop-2.7 -Dhadoop.version=2.7.0 -DskipTests clean package3.

4.Zinc:增量编译

增量编译是只编译那些源代码在上一次编译之后有修改的类,及那些受这些修改影响到的类,它可以大大减少 Scala 的编译时间。

所以如果多人在同一台机器上编译,会发生冲突。

Zinc编译过程:https://segmentfault.com/a/1190000005369936#articleHeader1

解决办法:关闭Zinc

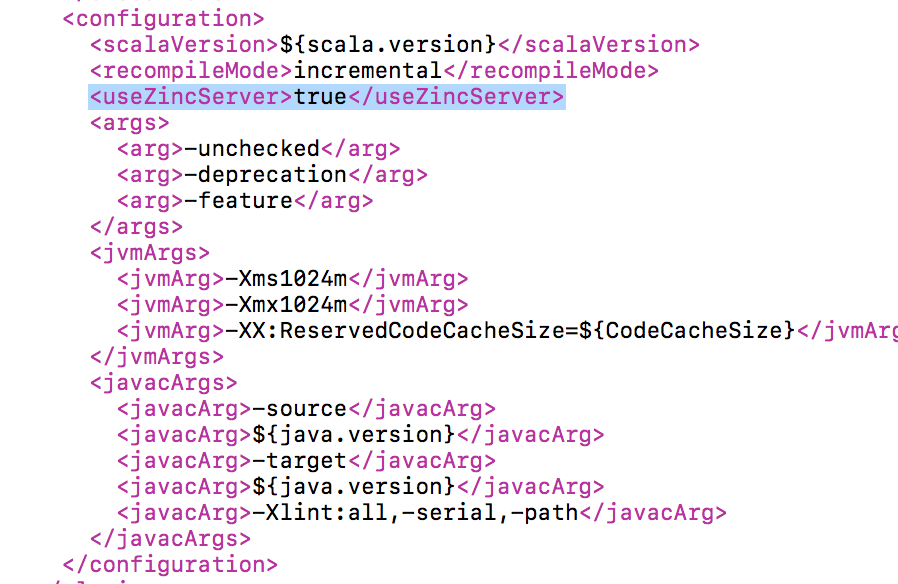

1.在spark/pom.xml中把true改为false

2.build/zinc-